les Ateliers Formation du Campus TERATEC

Tous les mois sont organisés sur le Campus TERATEC, à l’initiative de la CCIE et de TERATEC, des Ateliers Formations gratuits alternativement sur des thèmes animés par les membres de TERATEC, et sur des thèmes d’entreprises.

![]()

Programme 2018

Prise en main avancée du SaaS OpenSource HIPE pour le traitement visuel temps-réel

Atelier animé par ANEO

Jeudi 22 mars 2018 de 9h00 à 16h30 - Campus TERATEC - Bruyères-le-Chatel

|

Cet atelier s’adresse aux industriels le matin de l’atelier puis aux architectes logiciels et aux développeurs en traitement visuels complexes l’après-midi. Vous êtes les premiers à savoir que les nouveaux logiciels liés aux traitements visuels sont en plein essor mais éprouvent des difficultés à intégrer les nouvelles technologies. Ajoutez à cette situation la complexité et la généralisation des algorithmes de machine learning et vous obtiendrez une application qui fera douter de sa fiabilité dans les entreprises.

Né de ce constat, le projet HIPE (Hierarchic Image Processing Engine) est une solution OpenSource créée par ANEO ayant pour but de réduire le temps de développement et de faciliter notre travail au quotidien.

HIPE est une plateforme SaaS (Software as a service) dont la conception et le design sont représentés par un système de graphes d’algorithmes. Conçus « à chaud », ils sont exécutés dynamiquement par notre framework. La conception modulaire facilite l’interaction des développeurs et sépare naturellement le développement et le paramétrage des algorithmes. Les designs basés sur plusieurs traitements ou sur plusieurs systèmes de machines Learning s’en trouvent simplifiés et permettent d’imaginer un système plus robuste et propre à chaque entreprise.

Pendant cette journée, nous verrons ensemble plusieurs démonstrations d’utilisations et comment exploiter cette plateforme SaaS pour la conception de graphes d’algorithmes en traitement visuel.

|

Programme 2017

HPC et le cloud, panorama des solutions offertes par Altair

Jeudi 30 novembre 2017 de 14h00 à 17h30 - Campus TERATEC - Bruyères-le-Chatel

|

En quelques années, le cloud computing est devenu une solution quasiment incontournable dans le monde du HPC. Qu’il soit public, privé ou hybride, le cloud apporte une plus grande flexibilité d’utilisation dans de nombreux cas d’utilisation du HPC.

D’un autre côté, les fournisseurs de cloud, essentiellement américains, ont accéléré leur déploiement en Europe avec l’ouverture de nouveaux Datacenters, et proposé de nouveaux services dédiés aux usages du HPC (infinband, CPU Skylake, instance surchargée en CPU ou de RAM, GPU pour le calcul ou la visualisation distance,…).

Altair, grâce à ses deux nouveaux produits PBScontrol et PBScloud.io, permet de mettre en œuvre le scénario d’utilisation du cloud qui correspond le mieux aux besoins des utilisateurs de HPC, que ce soit un cloud privé, un cloud hybride ou un usage complet dans le cloud public. En alternant des présentations de besoin et des démonstrations plus techniques, cet atelier s’adresse aussi bien à des responsables de solution HPC souhaitant prendre connaissance des possibilités offertes par le cloud, qu’à des administrateurs de clusters HPC en recherche d’informations plus techniques sur les produits d’Altair.

Pour en savoir plus & Inscription >>>>

|

PARATOOLS - Utilisation avancée et évolution d’un runtime MPI basé sur les processus légers

Jeudi 9 novembre 2017 de 09h00 à 16h30 - Campus TERATEC - Bruyères-le-Chatel

|

Cet atelier s’adresse à des professionnels habitués à MPI souhaitant avoir des perspectives sur les évolutions du standard ainsi que sur les évolutions des implémentations MPI. Une approche originale d'implémentation MPI, le « thread-based », sera présentée en détail, dans le contexte du runtime MPC développé par le CEA, en partenariat avec ParaTools. Des évolutions futures, telles que l’arrivée de cartes réseau dédiées au MPI (telle que le Bull BXI) seront également décrites du point de vue d’une implémentation MPI.

L’évolution rapide des supercalculateurs pose de nombreux défis. Les applications doivent s’adapter aux nouvelles contraintes architecturales telles que le manycore. Cette adaptation peut se faire au travers de l’utilisation enrichie des standards de programmation parallèle. Dans cet atelier, nous nous proposons d’explorer les évolutions du standard MPI, considéré de facto pour l’expression d’un parallélisme distribué.

Pour en savoir plus & Inscription >>

|

Programme 2016

NOESIS - Capturez et Automatisez vos processus de simulation

Jeudi 17 mars 2016 de 14h00 à 17h00

|

Vous estimez que vous consacrez trop de temps pour la mise en données, l’exécution et l’évaluation des résultats de vos campagnes de simulation ?

Cet atelier abordera les techniques proposées par OPTIMUS pour la capture efficace et industrielle de processus de simulation mono et multidisciplinaires. Un composant essentiel concerne l’interface standardisée avec les logiciels de simulation commerciaux et/ou outils métiers de manière à accéder simplement aux paramètres et résultats des modèles de simulation.

On recherchera également l’efficience d’exécution par la mise en œuvre de capacités de parallélisation des campagnes de simulation et l’utilisation de ressources HPC. Enfin, la flexibilité et l’ouverture d’OPTIMUS permettra la réalisation d’applications métiers pour une meilleure diffusion des bonnes pratiques de conception/validation. Pour en savoir plus & Inscription >>>>

|

Analysez et calculez sans limite avec quasardb et DDN

Jeudi 24 mars 2016 de 14h00 à 17h00

|

Vous êtes invités à découvrir l’alliance technologique DDN-quasardb pour enfin dépasser toutes les limites !

Dans tous les domaines, de l’industriel au calcul scientifique en passant par la finance, les télécommunications ou l’audiovisuel, le volume des données traitées explose. L’infrastructure informatique doit être adaptée à ces nouvelles contraintes pour permettre de supporter plus d’accès simultanés, améliorer les temps de réponses, de plus en plus courts, et accéder à des données, de plus en plus volumineuses.

Pour éviter les goulots d’étranglement des architectures existantes, chaque composante de l’infrastructure doit jouer pleinement son rôle. Le plus petit composant inadapté mettra en péril, l’ensemble des performances nécessaire à la réussite du projet. Pour faire face à ces nouveaux défis, DDN et Quasardb mettent leurs technologies en commun pour apporter l’excellence et garantir la réussite de vos projets en parfaite harmonie.

La technologie quasardb permet à des logiciels de recherches, simulation ou d’analyse d’accéder en temps réel et de façon simple à des enregistrements très ciblés.

La technologie DDN est brevetée, éprouvée et reconnue pour ses performances et sa stabilité. DDN propose une gamme complète de stockage allant du mode Block (SAN), File (NAS) ou Stockage Objet particulièrement adapté aux archives actives et au backup. Elle se différentie par une performance inégalée garantie et une évolution sans limite à moindre coût.

L’objectif de cet atelier est de présenter la complémentarité des solutions et notamment de montrer à travers des benchmarks comment atteindre des niveaux de performance inégalés …

|

ENGINSOFT - Méta modèles pour l’optimisation multidisciplinaire et outils de validation

Jeudi 14 avril 2016 de 14h00 à 17h00

|

Présentation

Spécialisé dans le domaine de la simulation numérique depuis plus de 30 ans, EnginSoft a acquis une solide expérience dans les méthodes et les outils d’optimisation multidisciplinaire.

Romain Soulier, Responsable Technique à EnginSoft France, vous présentera les différents modules, outils de post-traitement et d’aide à la décision qui permettent d’améliorer les performances de vos produits et réduire les temps de développement, au cours d’un atelier d’une demi-journée sur le Campus de Teratec.

Objectifs .

|

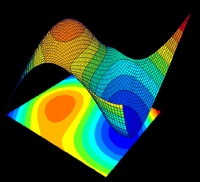

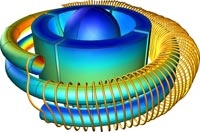

COMSOL - Simuler en CFD, Mécanique et Electromagnétisme avec le HPC

Jeud 21 avril 2016 de 14h00 à 17h00

|

Le fil rouge de cette présentation sera la simulation multiphysique et le calcul haute performance avec COMSOL.En particulier il s'agira de préciser les points clés à prendre en compte pour exploiter efficacement la puissance de calcul disponibleSimulation Multiphysique en CFD, Mécanique et Electromagnétisme avec le HPC

Atelier sur ordinateur

|

DISTENE - Visualisation/Post-traitement/Analyse de résultats de simulation numérique 3D avec EnSight

Jeudi 10 juin 2016 de 14h00 à 17h00

|

Post-traiter, Analyser, Visualiser et Communiquer ses résultats de simulation numérique 3D au sein d'un seul et même outil, est le crédo d'EnSight.Son efficacité est portée par la richesse de ses fonctionnalités, depuis l'analyse individuelle des phénomènes les plus complexes jusqu'au partage et la prise de décision en contexte collaboratif, et par sa grande convivialité d'usage.L'Atelier EnSight proposé est l'occasion de mieux connaitre EnSight : il est destiné aux utilisateurs soucieux d'exploiter au mieux le logiciel par rapport à leur application et usage. Après une brève introduction du logiciel et des intervenants, cette session se déroulera sous la forme d'une session de travail, au cours de laquelle des experts d'EnSight seront à votre disposition pour vous aider à optimiser son utilisation par rapport à vos besoins, vos cas d'études et votre environnement de travail.

Il est demandé à chaque participant d'amener son portable et ses cas d'études pour permettre cette session personnalisée.

|

MATHWORKS - MATLAB et le calcul haute performance au service des besoins métier des ingénieurs et analystes

Jeudi 6 octobre 2016 de 14h00 à 17h00

|

Comment les fonctionnalités de calcul parallèle de MATLAB peuvent être mises à contribution pour répondre aux besoins métier des ingénieurs et analystes?

Longtemps confiné aux mains de la communauté dite « HPC », aujourd’hui le calcul parallèle permet de répondre aux besoins métiers des ingénieurs et analystes (non experts du sujet) dans ce contexte de volumétrie de données/simulations continuellement en croissance.

Lors de ce séminaire gratuit, nous partagerons avec vous des exemples concrets couvrant les 3 thématiques suivantes :

|

Programme 2015

Présentation de quasardb le logiciel nosql de next generation

Jeudi 12 février 2015 de 14h00 à 17h00

|

Quasardb est à l’origine une preuve de concept pour évaluer les capacités réelles des ordinateurs multi-cœurs de dernière génération sous forme d’un système de stockage en mémoire. Ces travaux de recherche ont été basés sur les avancées théoriques récentes dans le domaine du logiciel massivement distribué, la gestion de la mémoire et les des entrées sorties haut débit.

Quasardb apporte une réponse convaincante et pérenne aux problèmes grandissants de la gestion et l’exploitation massive des données et est la solution idéale aux défis rencontrés dans la finance, la défense, l’aéronautique, les télécommunications et l’énergie.

Pour découvrir cette solution industrielle, nous proposons une présentation dédiée aux sociétés désireuses de découvrir les possibilités offertes par quasardb suivie d’un atelier spécifique sur l’analyse de cas pertinents pour l’assistance.

|

CD-adapco : Nouvelles techniques d’Exploration de Design pour les applications Multiphysiques

Jeudi 19 mars 2015 de 14h00 à 17h00

|

La formation a pour but de donner au nouvel utilisateur de STAR-CCM+ une compréhension de la méthodologie inhérente à la mise en donnée d’une simulation typique de CFD et une expérience dans l’utilisation du logiciel au travers de nombreux exemples.

La formation donne aussi à l’utilisateur l’occasion de discuter avec un ingénieur expérimenté à propos des applications STAR-CCM+ concernant son champ d’activité. Elle permet à l’utilisateur de se familiariser avec les processus associées au setup, lancement et post-traitement d’une simulation typique de CFD avec STAR-CCM+.

|

Introduction à COMSOL Multiphysics et son Application Builder

16 avril 2015 de 14h00 à 17h00

|

Introduction à COMSOL Multiphysics : Lors d'une première partie, nous présentons le logiciel et les étapes de réalisation d'un modèle: construction ou import des géométries, choix des matériaux et des physiques, maillage automatisé, définition du type d'analyse. Vous pourrez ainsi découvrir COMSOL Multiphysics ou approfondir vos connaissances sur la dernière version du logiciel.

Atelier sur ordinateur: prise en main du logiciel : La seconde partie du séminaire est consacrée à la prise en main de l'interface sur des exemples tutoriaux, notamment en sciences de la terre. Ce sera l'occasion d'échanger avec notre expert. Fort de cette expérience, vous pourrez pleinement poursuivre l'évaluation de COMSOL Multiphysics.

|

Initiation au profilage massivement parallèle avec les outils ParaTools

28 mai 2015 de 09h30 à 17h00

|

Afin de satisfaire les besoins des scientifiques dans l’évaluation des performances de leurs applications, nous présentons les outils de profilage TAU et ParaTools ThreadSpotter en complément d’autres outils tels que PAPI, Score-P et Vampir.

Cet atelier se concentrera sur la collecte des données de performance, l’analyse et l’optimisation. Après une présentation et une démonstration de la facilité avec laquelle les données de performance (profils et traces) peuvent être collectées grâce à l’instrumentation automatique de TAU (Tuning and Analysis Utility), l’atelier couvrira l’analyse de ces données et la recherche des sections de code inefficaces.

L’atelier comprendra des exemples de codes illustrants les différentes instrumentations et les possibilités de mesure proposées. Les outils de profilage couvriront des support exécutifs parallèles tels que MPC du CEA, MPI, OpenMP, pthread, CUDA et OpenCL.

|

MATLAB pour le calcul haute performance : de nouvelles fonctionnalités pour plus de rapidité

Jeudi 24 septembre 2015 de 14h00 à 17h00

|

Vous souhaitez diminuer considérablement vos temps de développement et de simulation grâce à MATLAB ?

Au cours de cet atelier, nous avons montreré comment les ingénieurs travaillant sous MATLAB pouvaient accéder de manière transparente à une puissance de calcul démultipliée et ainsi diminuer leur temps de simulation sans monopoliser leur machine de développement.

Nous avons couverts notamment les thématiques suivantes :

MATLAB est souvent plébiscité pour sa facilité d’utilisation et ses fonctionnalités sophistiquées couvrant de nombreux champs d’applications qui permettent de réduire significativement les temps de développement. Vous pourrez constater au cours de cet atelier que MATLAB représente également une alternative sérieuse aux implémentations C/C++/FORTRAN traditionnellement mises en œuvre dans le domaine du calcul haute performance.

|

NOESIS Analyse de Sensibilité et Optimisation Robuste : outils & approches méthodologiques

Jeudi 22 octobre 2015 de 14h00 à 17h00

|

Améliorer votre efficacité décisionnelle et la performance de vos produits

Cet atelier abordera les techniques d'exploration paramétriques de l'espace de conception, l'aide à la décision et les approches d'optimisation robuste grâce au progiciel OPTIMUS. Nous vous présenterons comment ces techniques vous permettent de transformer une conception acceptable en produit de référence.

|

Altair : Expérimentez de façon simple et directe les solutions cloud pour la simulation numérique

Jeudi 5 novembre 2015 de 14h00 à 17h00

|

|

Altair, du fait de son positionnement original (éditeur de logiciels de HPC + logiciels de simulation + société d’ingénierie), a été amené à développer des solutions à ces problèmes pour ses propres besoins et ceux de ses clients.

Nous vous proposons de les découvrir ici de façon directe et pratique.

|

Enginsoft : Optimisation multidisciplinaire et outils d'aide à la décision

Jeudi 10 décembre 2015 de 14h00 à 17h00

|

|

Objectifs de l'atelier

|

Programme 2014

MATLAB Day : nouveautés pour le calcul haute performance

27 novembre 2014

|

Au cours de cet atelier, les experts de MATHWORKS ont montré comment les ingénieurs travaillant sous MATLAB et Simulink pouvaient accéder, de manière transparente, à une puissance de calcul démultipliée et ainsi diminuer leur temps de simulation, sans monopoliser leur machine de développement.

Ont été couvertes notamment les problématiques suivantes : déport d'un calcul ou d'une simulation vers des serveurs de calcul - Accélération des temps d’exécution - Distribution et traitement de jeux de données volumineux sur des clusters de calcul - Parallélisation de fonctions statistiques, d'optimisation, de réseaux de neurones, de traitement d'image ou de signal, etc. |

Post-traitement et visualisation de résultats de simulation numérique avec EnSight

23 octobre 2014

|

Ce séminaire a été l'occasion de faire le point sur les dernières nouveautés de la version 10.1 du logiciel EnSight et de l'ensemble de sa gamme incluant les version HPC et VR. Il a également permis à certains participants de mieux connaitre EnSight.

A l'issue d'une session de présentation du logiciel, et plus particulièrement de la version 10.1, une session de travail a été proposée aux participants pendant laquelle des experts d'EnSight ont assisté les participants dans la prise en main du logiciel et de ses dernières fonctionnalités, pour les aider à optimiser son utilisation par rapport à leurs besoins et leur environnement de travail. |

Modélisation avec Comsols multiphysics

12 juin 2014

|

La première partie de cette atelier a permis aux participants de découvrir le logiciel et les étapes de réalisation d'un modèle: construction ou import des géométries, choix des matériaux et des physiques, maillage automatisé, définition du type d'analyse. |

Les réseaux sociaux et comment optimiser l’usage des reseaux sociaux pour une entreprise

22 mai 2014

Découverte de Scilab et de ses solutions d'accompagnement

27 mars 2014

|

La distribution Scilab est un logiciel open source de calcul numérique qui fournit un puissant environnement de développement pour l’ingénierie et les applications scientifiques. La distribution Scilab est composée de trois briques Scilab, Xcos et ATOMS et est positionnée comme l'alternative open source à différents logiciels commerciaux.

Scilab peut aussi jouer le rôle de plateforme unique permettant d'interconnecter des codes écrits dans différents langages de programmation dans un langage unique et unifié, de favoriser leur distribution, leur sauvegarde et leur utilisation. |

Rencontres des partenaires des entreprises

13 mars 2014

Présence d’expert comptable, juriste, financeur, organismes sociaux, assureurs se sont réunis afin de répondre aux questions des chefs d’entreprises